يشير البحث الذي أجرته شركة Deloitte إلى أن 23% فقط من المؤسسات تشعر بأنها مستعدة تمامًا لإدارة المخاطر المتعلقة بالذكاء الاصطناعي، مما يترك ثغرات كبيرة في الرقابة والأمن.

ما هي حوكمة الذكاء الاصطناعي؟

حوكمة الذكاء الاصط ناعي هي نظام السياسات والأطر والرقابة التي توجه كيفية تطوير الذكاء الاصطناعي واستخدامه وتنظيمه. وهي تضمن أن يعمل الذكاء الاصطناعي بشفافية ومساءلة وأمان عبر المؤسسات والصناعات والحكومات.

أصبحت حماية أنظمة الذكاء الاصطناعي بحيث تعمل بشكل آمن وأخلاقي ومتوافق مع اللوائح التنظيمية أولوية قصوى. فبدون الحوكمة المناسبة، يمكن أن تؤدي أنظمة الذكاء الاصطناعي إلى التحيز أو انتهاك المتطلبات التنظيمية أو أن تصبح مخاطر أمنية.

على سبيل المثال، قد تؤدي أداة توظيف الذكاء الاصطناعي المُدربة على بيانات التوظيف السابقة إلى إعطاء الأولوية لبعض الفئات السكانية على حساب فئات سكانية معينة دون قصد، مما يعزز الأنماط التمييزية. في قطاعات مثل الرعاية الصحية أو التمويل، يمكن أن يؤدي نشر الذكاء الاصطناعي دون الامتثال لقوانين حماية البيانات الإقليمية إلى انتهاكات تنظيمية وغرامات كبيرة.

بالإضافة إلى ذلك، يمكن استغلال نماذج الذكاء الاصطناعي المدمجة في الخدمات العامة الخدمات ضوابط كافية لمنع التهديدات من خلال محاولات الاستغلال الخبيثة، مما يعرض المؤسسات للهجمات الإلكترونية وتعطيل العمليات.

المبادئ الرئيسية لحوكمة الذكاء الاصطناعي

تشتمل استراتيجية حوكمة الذكاء الاصطناعي المحددة جيدًا على مبادئ أساسية تساعد المؤسسات في الحفاظ على السيطرة على عملية اتخاذ القرارات التي تعتمد على الذكاء الاصطناعي. ووفقاً لاستطلاع أجراه معهد بونيمون، فإن 54% من المشاركين في الاستطلاع قد تبنوا الذكاء الاصطناعي، في حين أن 47% من فرق الأمن أبلغوا عن مخاوفهم بشأن الثغرات التي قد تنشأ عن التعليمات البرمجية التي يولدها الذكاء الاصطناعي.

تُعد المبادئ الأساسية التالية أساسية للحوكمة الفعالة للذكاء الاصطناعي وتساعد في التخفيف من المخاطر التشغيلية والأمنية على حد سواء:

تحمي بروتوكولات الأمان نماذج الذكاء الاصطناعي من الهجمات المعادية، والتعديلات غير المصرح بها، والتهديدات السيبرانية الناشئة

تضمن المساءلة وجود رقابة مخصصة لأنظمة الذكاء الاصطناعي، مما يمنع اتخاذ القرارات غير المنظمة ويعزز الرقابة البشرية

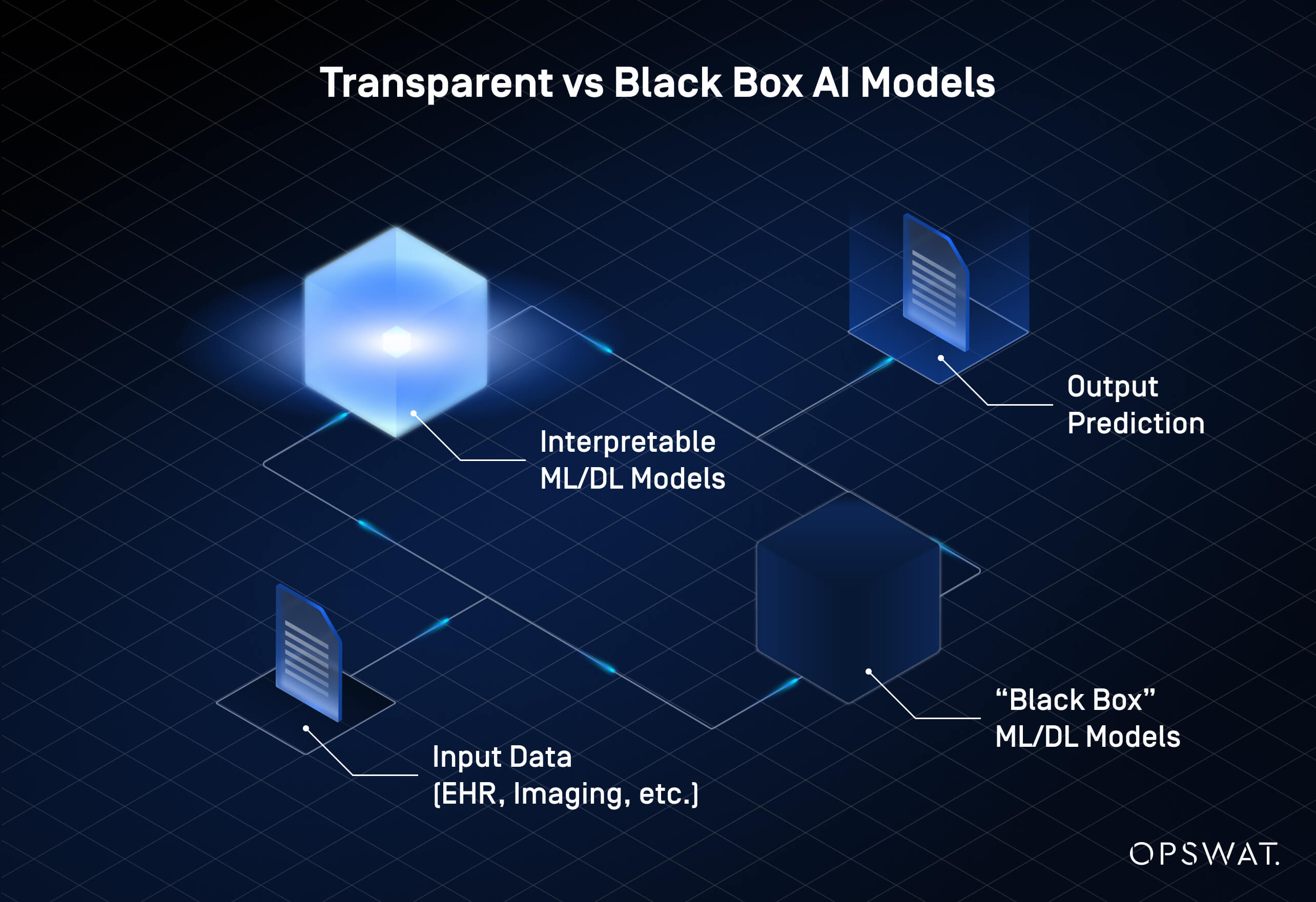

تتطلب الشفافية أن تقدم نماذج الذكاء الاصطناعي رؤى واضحة حول عمليات اتخاذ القرار الخاصة بها، مما يقلل من مخاطر نماذج الصندوق الأسود التي تفتقر إلى قابلية التفسير

من خلال تضمين هذه المبادئ في أطر الحوكمة، يمكن للمؤسسات التخفيف من المخاطر مع الحفاظ على كفاءة تقنيات الذكاء الاصطناعي وقابليتها للتطوير.

الحاجة المتزايدة لإدارة مخاطر الذكاء الاصطناعي

أدى الاعتماد السريع للذكاء الاصطناعي إلى ظهور تحديات جديدة في إدارة المخاطر والامتثال. فبدون استراتيجيات تكيفية، تواجه المؤسسات خطر التخلف في مواجهة التهديدات الناشئة والضغوط التنظيمية.

تركز إدارة مخاطر الذكاء الاصطناعي على:

- تضمن مواءمة استراتيجيات الحوكمة مع اللوائح التنظيمية المتطورة وتفويضات الإشراف على الذكاء الاصطناعي الخاصة بالصناعة تلبية المؤسسات للمتطلبات القانونية

- من الضروري إجراء عمليات تدقيق مستمرة للكشف عن التحيز والتدقيق في الإنصاف لمنع الأنماط التمييزية في عملية صنع القرار في الذكاء الاصطناعي

- تشكل هجمات التصيد الاحتيالي المعززة بالذكاء الاصطناعي، والاحتيال العميق، والتلاعب بالنماذج مخاوف متزايدة، مما يتطلب اتخاذ تدابير أمنية استباقية

وللبقاء في صدارة هذه المخاطر، يجب على المؤسسات أن تدمج حوكمة الذكاء الاصطناعي في أطر إدارة المخاطر الأوسع نطاقاً، بما يضمن أن تظل اعتبارات الامتثال والأمن والاعتبارات الأخلاقية جزءاً لا يتجزأ من عملية تطوير الذكاء الاصطناعي ونشره.

أطر حوكمة الذكاء الاصطناعي

يساعد إطار الحوكمة المنظم للذكاء الاصطناعي المؤسسات على التعامل مع متطلبات الامتثال وإدارة المخاطر ودمج التدابير الأمنية في أنظمة الذكاء الاصطناعي. إن دمج نموذج واضح لحوكمة الأمن في أطر عمل إدارة مخاطر الذكاء الاصطناعي يقلل من تجزئة مبادرات الذكاء الاصطناعي ويعزز تغطية الامتثال.

تطوير الإطار

يتطلب تطوير إطار حوكمة الذكاء الاصطناعي نهجًا استراتيجيًا يتماشى مع السياسات التنظيمية والمعايير التنظيمية. وتمثل العناصر التالية المكونات الأساسية لعملية وضع إطار عمل فعال:

تقييم المخاطر

تحديد نقاط الضعف في نماذج الذكاء الاصطناعي، بما في ذلك التحيز والمخاوف المتعلقة بالخصوصية والتهديدات الأمنية.

التكامل التنظيمي

ضمان توافق حوكمة الذكاء الاصطناعي مع المتطلبات الخاصة بالصناعة والمعايير العالمية.

التعاون متعدد الوظائف

إنشاء إطار حوكمة يعالج كلاً من المخاوف الأخلاقية والاحتياجات التشغيلية.

التكامل مع السياسات التنظيمية الحالية

لا ينبغي أن تعمل حوكمة الذكاء الاصطناعي بمعزل عن سياسات الشركة الأوسع نطاقاً بشأن الأمن السيبراني والأخلاقيات وإدارة المخاطر. إن دمج سياسات الذكاء الاصطناعي في إدارة المخاطر المؤسسية يضمن امتثال نماذج الذكاء الاصطناعي لبروتوكولات الأمان والمبادئ التوجيهية الأخلاقية.

يمكن أن تساعد آليات التدقيق بالذكاء الاصطناعي في الكشف المبكر عن حالات الإخفاق في الحوكمة، بينما يتيح تتبع الامتثال للمؤسسات البقاء في صدارة اللوائح المتطورة. كما يمكن للشراكات الخارجية مع موردي الذكاء الاصطناعي ومزودي خدمات الأمان أن تعزز استراتيجيات الحوكمة، مما يقلل من المخاطر المرتبطة حلول الذكاء الاصطناعي من أطراف ثالثة.

استراتيجيات التنفيذ

تتطلب الحوكمة الناجحة للذكاء الاصطناعي نهجًا منظمًا للتنفيذ، يستفيد من كل من الاستراتيجيات القائمة على التكنولوجيا والسياسات. تتجه العديد من المؤسسات إلى أدوات الامتثال المدعومة بالذكاء الاصطناعي أدوات عمليات الحوكمة واكتشاف الانتهاكات التنظيمية في الوقت الفعلي. تشمل تدابير التنفيذ الرئيسية ما يلي:

- تستخدم حلول الامتثال القائمة على التكنولوجيا الذكاء الاصطناعي لتتبع الالتزام بالسياسات ومراقبة عوامل المخاطر وأتمتة إجراءات التدقيق.

- تضمن استراتيجيات إدارة التغيير اعتماد سياسات حوكمة الذكاء الاصطناعي في جميع أنحاء المؤسسة

- يعالج التخطيط للاستجابة للحوادث المخاطر الأمنية الخاصة بالذكاء الاصطناعي، مما يضمن أن يكون لدى المؤسسات تدابير استباقية لإدارة إخفاقات الحوكمة والهجمات الإلكترونية والانتهاكات الأخلاقية

من خلال تضمين أطر الحوكمة في السياسات الحالية واعتماد استراتيجيات تنفيذ منظمة، يمكن للمؤسسات ضمان أن تظل أنظمة الذكاء الاصطناعي آمنة وأخلاقية ومتوافقة.

المبادئ التوجيهية الأخلاقية والمساءلة

نظرًا لأن أنظمة الذكاء الاصطناعي تؤثر على القرارات ذات المخاطر العالية، يجب على المؤسسات وضع مبادئ توجيهية أخلاقية وهياكل مساءلة لضمان الاستخدام المسؤول. فبدون ضمانات الحوكمة، يمكن أن يؤدي الذكاء الاصطناعي إلى التحيز أو تعريض الأمن للخطر أو العمل خارج الحدود التنظيمية.

وضع المبادئ التوجيهية الأخلاقية

تركز الحوكمة الأخلاقية للذكاء الاصطناعي على العدالة والشفافية والأمان. الممارسات التالية ضرورية لبناء أساس أخلاقي في تطوير الذكاء الاصطناعي ونشره:

- تساعد المبادئ والمعايير الأخلاقية للذكاء الاصطناعي على ضمان عمل الذكاء الاصطناعي ضمن حدود مقبولة، وتجنب العواقب غير المقصودة

- يؤدي وضع مدونة أخلاقيات إلى إضفاء الطابع الرسمي على الاستخدام المسؤول للذكاء الاصطناعي، ووضع مبادئ توجيهية واضحة بشأن الشفافية وخصوصية البيانات والمساءلة

إنشاء هياكل المساءلة

ولضمان أن تكون حوكمة الذكاء الاصطناعي قابلة للتنفيذ، تحتاج المؤسسات إلى آليات تتبع الامتثال وتمكين الإجراءات التصحيحية. تشمل تدابير المساءلة الشائعة ما يلي:

- تقيّم عمليات تدقيق الذكاء الاصطناعي أداء النموذج، والامتثال، ونقاط الضعف الأمنية

- يعمل التخطيط للاستجابة للحوادث على إعداد المؤسسات لمعالجة الإخفاقات المتعلقة بالذكاء الاصطناعي والانتهاكات الأمنية وثغرات الحوكمة

من خلال تضمين المبادئ التوجيهية الأخلاقية وتدابير المساءلة في أطر الحوكمة، يمكن للمؤسسات إدارة مخاطر الذكاء الاصطناعي مع الحفاظ على الثقة والامتثال.

الأطر التنظيمية

يُعد الامتثال للأطر التنظيمية أمرًا بالغ الأهمية، ومع ذلك تكافح العديد من المؤسسات لمواكبة السياسات المتطورة. وفقًا لشركة Deloitte، يُعد عدم اليقين التنظيمي أحد أهم العوائق أمام تبني الذكاء الاصطناعي، حيث تقوم العديد من الشركات بتنفيذ هياكل الحوكمة لمعالجة مخاطر الامتثال.

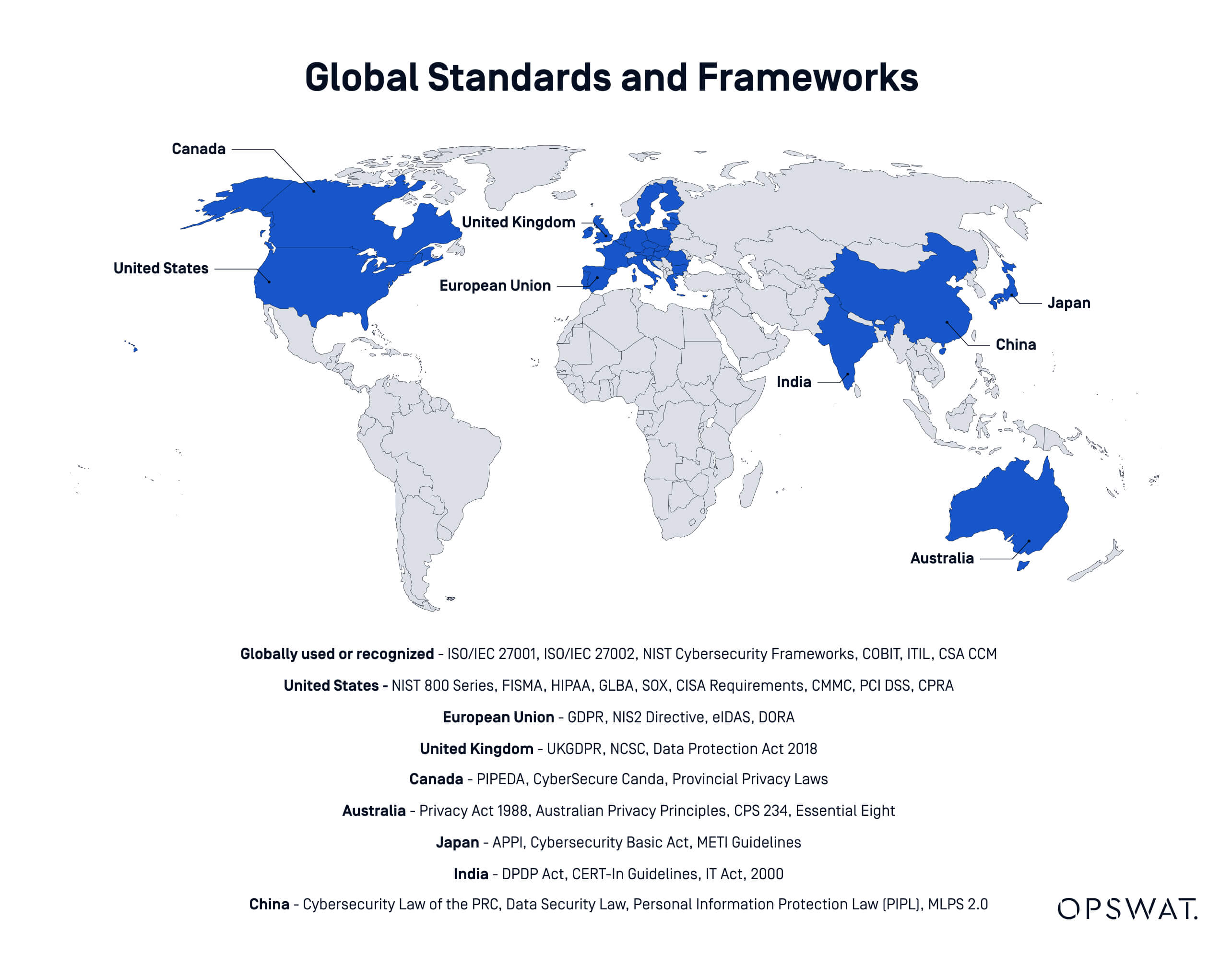

نظرة عامة على اللوائح العالمية

تتشكل حوكمة الذكاء الاصطناعي من خلال قوانين خاصة بكل منطقة، ولكل منها متطلبات امتثال متميزة. توضح الأمثلة أدناه كيف تختلف اللوائح عبر الولايات القضائية الرئيسية:

- ينص قانون الاتحاد الأوروبي للذكاء الاصطناعي على رقابة صارمة تتطلب الشفافية وتقييم المخاطر والإشراف البشري على تطبيقات الذكاء الاصطناعي عالية المخاطر. وفقًا للمادة 6، تُعتبر أنظمة الذكاء الاصطناعي عالية المخاطر إذا كانت تعمل في قطاعات البنية التحتية الحيوية. يجب على المؤسسات العاملة في الاتحاد الأوروبي مواءمة سياسات الذكاء الاصطناعي الخاصة بها مع هذه المبادئ التوجيهية.

- يحدد تقرير الولايات المتحدة SR-11-7 توقعات إدارة المخاطر للذكاء الاصطناعي في المؤسسات المالية، مع التركيز على التحقق من صحة النموذج والحوكمة والضوابط الأمنية. وتظهر مبادئ توجيهية مماثلة خاصة بقطاعات محددة في مختلف القطاعات.

- تشدد السياسات الدولية الأخرى، بما في ذلك اللوائح التنظيمية في كندا وسنغافورة والصين، على الاستخدام الأخلاقي للذكاء الاصطناعي وحماية المستهلك ومسؤولية الشركات. يجب على الشركات تتبع التطورات التنظيمية في المناطق التي تستخدم فيها الذكاء الاصطناعي.

من خلال تضمين المبادئ التوجيهية الأخلاقية وتدابير المساءلة في أطر الحوكمة، يمكن للمؤسسات إدارة مخاطر الذكاء الاصطناعي مع الحفاظ على الثقة والامتثال.

استراتيجيات الامتثال

يتطلب ضمان الامتثال للوائح الذكاء الاصطناعي نهجًا استباقيًا. تساعد الاستراتيجيات التالية المؤسسات على مواءمة أطر الحوكمة مع المتطلبات القانونية المتطورة، خاصةً عند العمل مع أنظمة الذكاء الاصطناعي عالية المخاطر:

- يتيح إنشاء فريق الامتثال للمؤسسات إدارة المخاطر التنظيمية، والإشراف على عمليات تدقيق الذكاء الاصطناعي، وتنفيذ تدابير الحوكمة المطلوبة

- ينطوي التعامل مع التحديات التنظيمية على المراقبة المستمرة للتغييرات في السياسات مع تكييف هياكل الحوكمة في بيئة معقدة من اللوائح التنظيمية المتداخلة في كثير من الأحيان

- تساعد عمليات التدقيق وإعداد التقارير التنظيمية المؤسسات على إثبات الامتثال ومنع المخاطر القانونية من خلال المراقبة الاستباقية

من خلال تضمين استراتيجيات الامتثال في أطر حوكمة الذكاء الاصطناعي، يمكن للمؤسسات التخفيف من المخاطر التنظيمية مع ضمان بقاء الذكاء الاصطناعي أخلاقيًا وآمنًا.

الشفافية وقابلية الشرح

تواجه المؤسسات ضغطاً متزايداً لجعل القرارات التي تعتمد على الذكاء الاصطناعي قابلة للتفسير، لا سيما في التطبيقات عالية المخاطر مثل التمويل والرعاية الصحية والأمن السيبراني. وعلى الرغم من ذلك، لا تزال العديد من نماذج الذكاء الاصطناعي معقدة، مما يحد من وضوح الرؤية حول كيفية عملها.

تصميم أنظمة ذكاء اصطناعي شفافة

تتضمن شفافية الذكاء الاصطناعي جعل عمليات اتخاذ القرار مفهومة لأصحاب المصلحة والمنظمين والمستخدمين النهائيين. تدعم النُهج التالية إمكانية شرح الذكاء الاصطناعي وتساعد في التخفيف من المخاطر المرتبطة بما يسمى بنماذج الذكاء الاصطناعي ذات الصندوق الأسود التي لا يمكن فهم طريقة عملها الداخلية بسهولة:

- تساعد استراتيجيات التواصل الفعالة المؤسسات على ترجمة عملية صنع القرار في مجال الذكاء الاصطناعي إلى مخرجات واضحة وقابلة للتفسير. ويمكن أن يؤدي توفير الوثائق وملخصات النماذج وتقييمات الأثر إلى تحسين الشفافية.

- تضمن أدوات الشفافية تفسير الذكاء الاصطناعي من خلال تقديم رؤى حول كيفية معالجة نماذج الذكاء الاصطناعي للبيانات وتوليد النتائج. تساعد أدوات تدقيق الذكاء الاصطناعي وأطر التفسير وتقنيات الذكاء الاصطناعي القابل للتفسير (XAI) في التخفيف من المخاوف المتعلقة باتخاذ القرارات غير الشفافة.

من خلال إعطاء الأولوية للشفافية، يمكن للمؤسسات تحسين المواءمة التنظيمية وتقليل المخاطر المتعلقة بالتحيز وبناء الثقة في تطبيقات الذكاء الاصطناعي.

المراقبة والتحسين المستمر

تُعد حوكمة الذكاء الاصطناعي عملية مستمرة تتطلب المراقبة المستمرة وتقييم المخاطر وتنقيحها لضمان الأمن والامتثال. نظرًا لأن الأنظمة القائمة على الذكاء الاصطناعي تتعامل مع كميات متزايدة من البيانات الحساسة، يجب على المؤسسات إنشاء تدفقات عمل آمنة لمنع الوصول غير المصرح به والانتهاكات التنظيمية.

حلول نقل الملفات المُدارة دوراً حاسماً في إنفاذ سياسات الذكاء الاصطناعي، والحفاظ على قابلية التدقيق، وتقليل مخاطر عدم الامتثال في عمليات تبادل البيانات المدعومة بالذكاء الاصطناعي.

مقاييس الأداء وحلقات التغذية الراجعة

يعد تتبع أداء نظام الذكاء الاصطناعي أمرًا ضروريًا لضمان الموثوقية والأمان والامتثال. تساهم الممارسات التالية في المراقبة القوية والحوكمة التكيفية:

- تمنع سير عملSecure الوصول غير المصرح به وتضمن أن عمليات تبادل البيانات المدعومة بالذكاء الاصطناعي تتبع سياسات أمنية صارمة. يتيح MetaDefender Managed File Transfer MFT)™ OPSWATللمؤسسات فرض التشفير وضوابط الوصول والمراقبة الآلية للامتثال لتقليل مخاطر تعرض البيانات.

- تسمح آلياتAdaptive لنماذج الذكاء الاصطناعي بتحسين عملية صنع القرار استنادًا إلى التغذية الراجعة المستمرة مع الحفاظ على تدابير أمنية وتوافقية صارمة. تساعد حلول الأمان المدعومة بالذكاء الاصطناعي، مثل Managed File Transfer ، في تصنيف البيانات الحساسة في الوقت الفعلي، مما يضمن الالتزام بالمتطلبات التنظيمية المتطورة.

بناء أطر عمل المخاطر من أجل التحسين المستمر

يجب تقييم سير العمل المدعوم بالذكاء الاصطناعي بشكل مستمر بحثًا عن نقاط الضعف، لا سيما مع تطور التهديدات السيبرانية. وفقًا للمنتدى الاقتصادي العالمي، أبلغت 72% من المؤسسات التي تم سؤالها عن ارتفاع المخاطر السيبرانية خلال العام الماضي، مدفوعةً بزيادة في التصيد الاحتيالي والهندسة الاجتماعية وسرقة الهوية والاحتيال الإلكتروني. تدعم الاستراتيجيات التالية المرونة على المدى الطويل:

- يحمي تطبيق الأمان المدعوم بالذكاء الاصطناعي عمليات تبادل بيانات الذكاء الاصطناعي من خلال دمج الكشف المتقدم عن التهديدات ومنع فقدان البياناتوضوابط الامتثال. يضمن MetaDefender Managed File Transfer MFT)™ للمؤسسات إمكانية نقل البيانات الحساسة المتعلقة بالذكاء الاصطناعي بأمان دون زيادة التعرض للمخاطر التنظيمية.

- يعمل تطبيق الامتثال الآلي على تبسيط الالتزام باللوائح التنظيمية من خلال تطبيق سياسات أمان محددة مسبقًا على جميع عمليات نقل الملفات المتعلقة بالذكاء الاصطناعي. من خلال الاستفادة من حلول الحوكمة المدعومة بالذكاء الاصطناعي، يمكن للمؤسسات تقليل مخاطر انتهاكات البيانات مع الحفاظ على الكفاءة التشغيلية.

من خلال دمج سير عمل البيانات الآمن في استراتيجيات حوكمة الذكاء الاصطناعي، يمكن للمؤسسات تعزيز الأمان والحفاظ على الامتثال وضمان سلامة عملية صنع القرار المدعومة بالذكاء الاصطناعي. توفر حلول MetaDefender Managed File Transfer MFT) الضمانات اللازمة لدعم عمليات الذكاء الاصطناعي الآمنة والمتوافقة.

MetaDefender Managed File Transfer MFT) – حل الأمن والامتثال القائم على الذكاء الاصطناعي

يلعب MetaDefender Managed File Transfer MFT) دورًا مهمًا في إدارة أمن الذكاء الاصطناعي من خلال توفير:

- عمليات نقل الملفات المعززة بالسياسات التي تطبق ضوابط الأمان تلقائياً، مثل قيود الوصول ومتطلبات التشفير والتحقق من الامتثال

- الوقاية المتقدمة من التهديدات من خلال الكشف متعدد الطبقات الذي يحدد ويحظر البرمجيات الخبيثة، وبرامج الفدية، والبرامج النصية المضمنة وغيرها من التهديدات القائمة على الملفات التي يشيع استخدامها في الهجمات التي يولدها الذكاء الاصطناعي

- تدابير أمنية مدفوعة بالامتثال تدعم التفويضات التنظيمية بما في ذلك اللائحة العامة لحماية البيانات (GDPR) وPCI DSS وNIS2 من خلال دمج تسجيل التدقيق، وعناصر التحكم في الوصول المستند إلى الأدوار، وإنفاذ السياسة القابلة للتخصيص

- تدفقات عملSecure ومدارة للبيانات تضمن تشفير عمليات نقل الملفات التي تعتمد على الذكاء الاصطناعي (AES-256، TLS 1.3)، والتحقق من تكاملها وحمايتها من التلاعب أو حقن حمولات خبيثة خلال عملية التبادل

- By integrating Multiscanning with heuristic and machine learning engines, Deep CDR™ Technology and AI-powered sandboxing technologies, MetaDefender Managed File Transfer (MFT) protects AI-generated data from evolving cyberthreats while ensuring adherence to AI governance regulations.

تأمين سير عمل البيانات المستند إلى الذكاء الاصطناعي

تعتمد نماذج الذكاء الاصطناعي على كميات كبيرة من البيانات التي غالبًا ما تنتقل بين أنظمة متعددة، مما يجعل عمليات نقل البيانات الآمنة أمرًا ضروريًا. وبدون الضوابط المناسبة، يمكن أن تكون البيانات التي يتم إنشاؤها ومعالجتها بالذكاء الاصطناعي عرضة للتلاعب أو الوصول غير المصرح به أو انتهاكات الامتثال.

يضمن MetaDefender Managed File Transfer MFT) حماية سير عمل البيانات المدعوم بالذكاء الاصطناعي من خلال:

- التشفير من طرف إلى طرف باستخدام AES-256 وTLS 1.3، لتأمين البيانات أثناء النقل وفي السكون

- مصادقة صارمة وعناصر تحكم صارمة في الوصول مع تكامل Active Directory، وSSO (تسجيل الدخول الأحادي) والمصادقة متعددة العوامل (MFA) لمنع تبادل البيانات غير المصرح به

- التحقق من سلامة البيانات من خلال التحقق من صحة المجموع الاختباري، مما يضمن عدم التلاعب بالملفات التي تم إنشاؤها بالذكاء الاصطناعي أثناء عمليات النقل

من خلال تطبيق هذه التدابير الأمنية، يمكن للمؤسسات دمج العمليات القائمة على الذكاء الاصطناعي بأمان في بنيتها التحتية الحالية دون تعريض البيانات الحساسة للمخاطر.

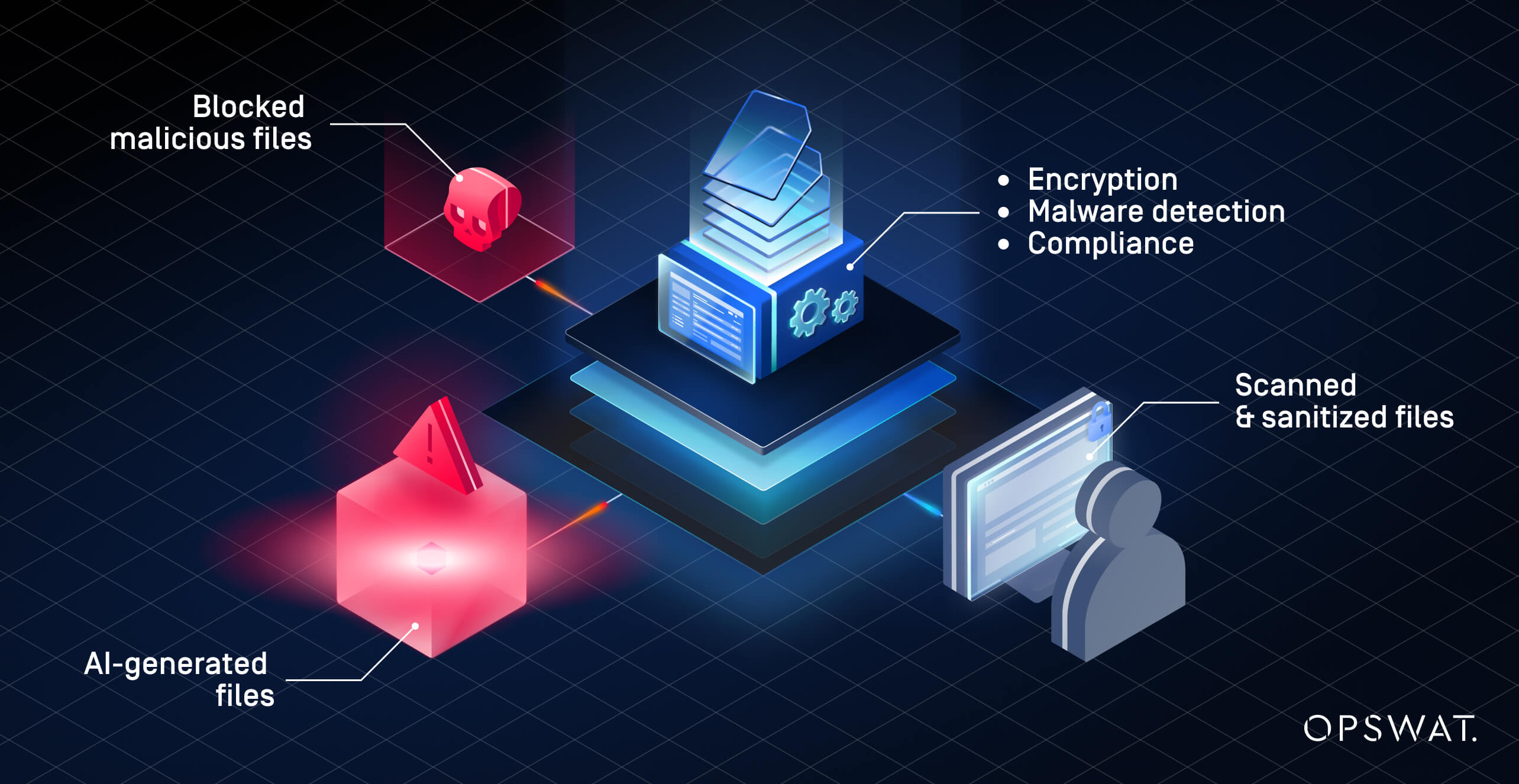

الوقاية من التهديدات المدعومة بالذكاء الاصطناعي

يُشكل المحتوى الذي يتم إنشاؤه بواسطة الذكاء الاصطناعي تحديات أمنية جديدة، بما في ذلك هجمات الذكاء الاصطناعي العدائية والبرامج الضارة المدمجة والاستغلالات القائمة على الملفات. يعزز MetaDefender Managed File Transfer MFT) الأمان من خلال طبقات متعددة من الحماية، مما يمنع الهجمات الإلكترونية المدعومة بالذكاء الاصطناعي قبل وصولها إلى الأنظمة الحيوية.

تستفيد تقنية Metascan™ Multiscanning من أكثر من 30 محركاً لمكافحة البرمجيات الخبيثة لاكتشاف التهديدات المعروفة والتهديدات التي لا يمكن اكتشافها في يوم الصفر، مما يضمن خلو الملفات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي من الحمولات الخبيثة. تعرّف على المزيد حول هذه التقنية هنا.

Deep CDR™ Technology removes hidden threats, stripping active content from files while preserving usability—a critical step for preventing AI-generated exploits. Read more how it works here.

MetaDefender Sandbox™ detects evasive malware by executing suspicious AI-exchanged files in an isolated environment, analyzing their behavior to uncover تهديدs undetectable by traditional security measures. اقرأ ما يقوله العملاء عن هذه التقنية هنا.

هذه القدرات تجعل MetaDefender Managed File Transfer MFT) حلاً أمنياً شاملاً للمؤسسات التي تعتمد على تبادل البيانات المدعوم بالذكاء الاصطناعي وتحتاج في الوقت نفسه إلى منع تسلل البرامج الضارة وانتهاكات الامتثال.

حوكمة الذكاء الاصطناعي القائمة على الامتثال

تخضع البيانات التي يتم إنشاؤها بواسطة الذكاء الاصطناعي لرقابة تنظيمية صارمة، مما يتطلب من المؤسسات تنفيذ سياسات أمنية تضمن الامتثال للأطر القانونية المتطورة. يساعد MetaDefender Managed File Transfer MFT) الشركات على تلبية هذه المتطلبات من خلال دمج ضوابط الامتثال الاستباقية في كل عملية نقل ملفات:

- تفحص تقنية DLP™ الاستباقية DLP™ الملفات التي يتم إنشاؤها بالذكاء الاصطناعي بحثًا عن المحتوى الحساس، مما يمنع انكشاف البيانات غير المصرح به ويضمن الامتثال للوائح مثل اللائحة العامة لحماية البيانات GDPR وPCI DSS وNIS2

- توفر سجلات التدقيق الشاملة وتقارير الامتثال رؤية واضحة لعمليات نقل الملفات المتعلقة بالذكاء الاصطناعي، مما يسمح للمؤسسات بتتبع الوصول والتعديلات وتطبيق السياسة

- تفرض ضوابط الوصول المستندة إلى الأدوار (RBAC) أذونات دقيقة، مما يضمن أن المستخدمين المصرح لهم فقط هم من يمكنهم الوصول إلى الملفات المتعلقة بالذكاء الاصطناعي أو نقلها وفقًا لسياسات الحوكمة

بفضل هذه القدرات الإدارية، لا يقتصر دور MetaDefender Managed File Transfer MFT) على تأمين بيانات الذكاء الاصطناعي فحسب، بل يساعد المؤسسات أيضًا على الامتثال للمتطلبات التنظيمية، مما يقلل من المخاطر القانونية والتشغيلية المرتبطة بالعمليات التي تعتمد على الذكاء الاصطناعي.

تعزيز أمن الذكاء الاصطناعي باستخدام MetaDefender Managed File Transfer MFT)

تتطلب سير عمل البيانات المدعومة بالذكاء الاصطناعي ضوابط أمان وامتثال قوية. يوفر MetaDefender Managed File Transfer MFT) حلول متقدمة لمنع التهديدات والامتثال التنظيمي وتبادل البيانات الآمن حلول المدعومة بالذكاء الاصطناعي. تعرف على المزيد حول كيفيةMFT الحل الرائد في مجال نقل الملفات المدار OPSWAT لاستراتيجية حوكمة الذكاء الاصطناعي لديك.